دیپ وب (Deep Web) یا وب عمیق چیست؟

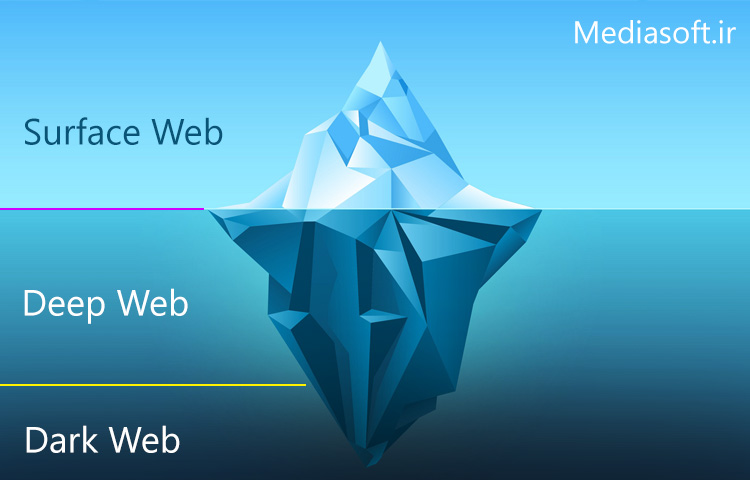

وب عمیق یا دیپ وب (Deep Web) و به عباراتی دیگر وب نامرئی یا وب پنهان بخش هایی از شبکه وب جهان گستر ( World Wide Web ) هستند که محتوایشان توسط موتور های جستجوی معمولی فهرست بندی نمی شود.

به نقل از مدیا سافت

عبارت مخالف وب عمیق، وب سطحی است که امکان دسترسی به آن برای هر کسی که از اینترنت استفاده می کند، وجود دارد. مایکل برگمن که یک دانشمند علوم کامپیوتر است اولین بار این عبارت را در سال ۲۰۰۱ به عنوان یک عبارت مربوط به فهرست بندی موتورهای جستجو ابداع کرد.

محتوای وب عمیق پشت فرمهای HTTP پنهان میشود و کاربردهای معمول مانند سرویسهای ایمیل، بانکداری اینترنتی و سرویسهایی که کاربران باید برای استفاده از آنها مبلغی را پرداخت کنند را در برمیگیرد. این سرویسها توسط دیوارهای پرداخت محافظت میشوند. نمونهای از این سرویسها، سایتهای تماشای ویدئوی دلخواه یا برخی مجلهها یا روزنامههای اینترنتی است.

محتوای وب عمیق را میتوان با استفاده از URL مستقیم یا آدرس IP، پیدا کرد. ممکن است برای دسترسی کامل به این نوع محتواها، بعد از عبور از صفحه عمومی وبسایت به رمزعبور یا انواع دیگری از اجازه دسترسی نیاز باشد.

واژه شناسی دیپ وب (Deep Web)

اولین تلفیق دو عبارت وب عمیق یا همان دیپ وب و وب تاریک (دارک وب) در سال ۲۰۰۹ و در زمانی که واژه شناسی اصطلاحات مورد استفاده در جستجوی های وب عمیق در کنار فعالیت های غیرقانونی در وب آزاد و وب تاریک مورد بحث قرار می گرفتند، اتفاق افتاد.

از آن زمان به بعد و پس معرفی بازار اینترنتی راه ابریشم در رسانه ها، بسیاری از مردم و رسانه ها به استفاده از عبارت وب عمیق به صورت معادل عبارت های وب تاریک یا دارک نت روی آوردند. البته برخی از افراد این استفاده معادل از کلمات را غیردقیق می دانند و همین موضوع به منبع اصلی سردرگمی تبدیل شده است. کیم زتر و اندی گرینبرگ، خبرنگاران مجله ی Wired توصیه کرده اند هر کدام از این عبارت ها به صورت مجزا نسبت به یکدیگر به کار بروند. در حالی که منظور از وب عمیق، هر سایتی است که امکان دسترسی به آن از طریق موتور های جستجوی معمولی وجود ندارد، وب تاریک، بخشی از وب عمیق است که به صورت تعمدی مخفی شده و از طریق مرورگرها و روش های معمولی قابل دسترسی نیست.

محتوای فهرست بندی نشده

برگمن در مقاله ای در زمینه وب عمیق که در ژورنال علمی Journal of Electronic Publishing منتشر شد به این نکته اشاره کرد که در سال ۱۹۹۴، جیل السورت، از عبارت وب نامرئی برای اشاره به وب سایت هایی استفاده کرد که در هیچ موتور جستجویی ثبت نشده بودند. برگمن در این مقاله به مقاله دیگری که در ژانویه ۱۹۹۶ توسط فرانک گارسیا نوشته شده بود نیز استناد کرد:

“منظور سایتی است که احتمالا به خوبی طراحی شده اما طراحان، خود را برای ثبت کردن آن در موتور های جستجو به دردسر نینداختند. پس هیچکس نمی تواند آن ها را پیدا کند! کاملا مخفی هستید! من به این حالت وب نامرئی می گویم”

یکی دیگر از از اولین موارد استفاده از عبارت وب نامرئی توسط بروس مونت و متیو کول از شرکت Personal Library Software بود. در سال ۱۹۹۶، آن ها از این عبارت در بیانیه ای مطبوعاتی در توصیف اولین ابزار وب عمیق استفاده کردند.

اولین استفاده از عبارت خاص وب عمیق، که امروزه مورد پذیرش عموم قرار گرفته است در همان تحقیق سال ۲۰۰۱ برگمن اتفاق افتاد.

روش های فهرست بندی

روش هایی که مانع از فهرست شدن صفحات وب توسط موتور های جستجوی معمولی می شوند به یک یا چند دسته از دسته های زیر تعلق دارند:

وب زمینه ای: صفحاتی با محتوای مختلف برای سطوح دسترسی مختلف (یعنی بازه های مختلفی از آدرس IP یا مجموعه ای از سیات های بازدید شده قبلی)

محتوای پویا: صفحات پویا که معمولا در پاسخ به یک درخواست ثبت شده یا از طریق یک فرم، به خصوص اگر از المان های ورودی دامنه باز (مثل جاهای خالی متن) استفاده شود، قابل دسترسی هستند. رد کردن چنین جاهای خالی بدون داشتن دانش کافی در آن زمینه، کاری دشوار است.

محتوای دسترسی محدود: سایت هایی که به روش های فنی (استاندارد مستثنی کردن ربات ها، کپچاها یا دستور عدم ذخیره، که مانع از جستجوی موتور های جستجو در صفحات سایت شده و از ایجاد کپی های کش شده جلوگیری می کند)، دسترسی به صفحاتشان را محدود می کنند.

محتوای غیر HTML یا غیر متنی: محتوای متنی که در فایل های چندرسانه ای (عکس یا ویدیو) یا فایل های با فرمت خاص که موتور های جستجو با آن ها کاری ندارند، رمزنگاری شده است.

وب خصوصی: سایت هایی که به ثبت نام و وارد شدن نیاز دارند (منابع رمز دار)

محتوای اسکریپتی: صفحاتی که تنها از طریق لینک های ایجاد شده توسط جاوا اسکریپت قابل دسترسی هستند و همچنین محتواهایی که از طریق Flash یا Ajax به صورت پویا از وب سرور ها دانلود شده اند

نرم افزار: برخی از محتوا ها به صورت عمدی از اینترنت معمولی مخفی شده اند و تنها از طریق نرم افزار های خاص مانند Tor، I2P و سایر نرم افزار های دارک نت قابل دسترسی هستند. برای مثال، Tor به کاربران اجازه می دهد از طریق سرور های .onion به صورت ناشناس و با مخفی کردن IP آن ها، به وب سایت ها دسترسی داشته باشند.

محتوای لینک نشده: صفحاتی که هیچ لینکی از آن ها در صفحات دیگر وجود ندارد، ممکن است مانع دسترسی خزنده های وب به محتوا شوند. به این گونه محتوا، صفحات بدون بک لینک ( که با نام لینک های داخلی هم شناخته می شوند) گفته می شود. همچنین، موتور های جستجو همیشه همه ی بک لینک های موجود در صفحات جستجو شده را تشخیص نمی دهند.

آرشیو های وب: خدمات آرشیو وب مانند Wayback Machine به کاربران اجازه می دهند تا نسخه های آرشیو شده صفحات وب در گذر زمان را مشاهده کنند. این نسخه های آرشیو شده شامل وب سایت هایی است که اکنون غیر قابل دسترس هستند یا توسط موتور های جستجو مانند گوگل فهرست بندی نمی شوند.

محتوا در دیپ وب

اگرچه همواره این امکان وجود ندارد که بتوان به صورت مستقیم محتوای یک وب سرور را مشاهده کرد تا بتوان آن را فهرست بندی کرد اما احتمالا می توان به صورت غیر مستقیم به آن دسترسی پیدا کرد (به دلیل آسیب پذیری های کامپیوتری).

موتور های جستجو برای پیدا کردن محتوا در وب، از خزنده های وب استفاده می کنند که لینک های موجود را از طریق پورت های مجازی مشخص دنبال می کنند. این روش برای پیدا کردن محتوا در در وب سطحی ایده آل است اما معمولا برای وب عمیق جواب نمی دهد. برای مثال، این خزنده ها برای یافتن صفحات پویا که نتیجه درخواست های مختلف از بانک اطلاعاتی هستند، تلاش نمی کنند زیرا تعداد دقیق درخواست های ممکن، مشخص نیست. البته به این نکته اشاره شده که می توان با در نظر گرفتن لینک برای نتایج درخواست ها، این مشکل را تا حدودی حل کرد اما این کار می تواند به صورت غیرتعمدی، محبوبیت یکی از اعضای وب عمیق را افزایش دهد.

DeepPeep، Intute، Deep Web Technologies، Scirus و Ahmia.fr چند موتور جستجویی هستند که به وب عمیق دسترسی پیدا کرده اند. بودجه Intute به اتمام رسید و در حال حاضر تنها یک ارشیو استاتیک به شمار می رود. Scirus نیز در اواخر ژانویه ۲۰۱۳، بازنشسته شد.

محققان به دنبال راه هایی هستند که بتوان در وب عمیق به صورت خودکار خزید. این موضوع در مورد محتواهایی که تنها از طریق نرم افزار های خاص مثل تور قابل دسترسی هستند نیز صدق می کند. در سال ۲۰۰۱، سریرام رقوان و هکتور گارسیا مولینا (از دانشکده علوم کامپیوتر دانشگاه استنفرد) مدل معماری را برای خزنده وب پنهان ارائه کردند که از واژه های کلیدی ارائه شده توسط کاربر یا جمع آوری شده از رابط های درخواست استفاده می کرد تا برای یک فرم درخواست ارسال کند و در محتوای وب عمیق بخزد. الکساندروس انتولاس، پتروس زرفوس و جونگهو چو از دانشگاه UCLA خزنده وب پنهانی را ساختند که به صورت خودکار، درخواست های معناداری را برای پر کردن فرم های جستجو ایجاد می کرد. چندین زبان درخواست فرم (مانند DEQUEL) نیز ارائه شده اند که در کنار ایجاد یک درخواست، امکان استخراج داده های سازمان یافته را از صفحات نتایج فراهم می کنند. یکی دیگر از تلاش ها در این زمینه، DeepPeep است که پروژه ای در دانشگاه University of Utah بوده و حامی مالی آن بنیاد ملی علوم آمریکاست. این پروژه، منابع وب پنهان (وب فرم ها) در دامنه های مختلف را با کمک روش های جدید خزیدن متمرکز جمع آوری می کند.

موتور های جستجوی تجاری نیز شروع به جستجو برای پیدا کردن روش های دیگر برای خزیدن در وب عمیق کرده اند. پروتکل Sitemap (که اولین بار در سال ۲۰۰۵ توسط گوگل توسعه یافت و معرفی شد) و OAI-PMH مکانیزم هایی هستند که به موتور های جستجو و سایر علاقه مندان اجازه می دهند منابع وب عمیق در وب سرور های خاص را پیدا کنند. هر دو مکانیزم به وب سرور ها اجازه می دهند URL هایی که بر روی آن ها قابل دسترسی هستند را تبلیغ کنند و به این ترتیب امکان پیدا کردن خودکار منابعی را که به صورت مستقیم به وب سطحی لینک نشده اند، فراهم می کند.

سیستم آشکار سازی وب پنهان گوگل درخواست های ثبت شده برای هر فرم HTML را محاسبه کرده و صفحات HTML به دست آمده را به فهرست موتور جستجوی گوگل اضافه می کند. نتایج آشکار شده ناشی از پردازش هزاران درخواست در ثانیه برای محتوای وب عمیق هستند. در این سیستم، پیش محاسبه درخواست های ثبت شده با استفاده از سه الگوریتم صورت می گیرد:

انتخاب مقادیر ورودی به عنوان ورودی های جستجوی متنی که کلمات کلیدی را قبول می کنند

شناسایی ورودی هایی که تنها مقادیری از یک نوع خاص (مثلا تاریخ) را قبول می کنند

انتخاب تعداد کمی از ترکیب های ورودی که URL های مناسب برای ثبت در فهرست جستجوی وب را ایجاد می کنند

در سال ۲۰۰۸، برای راحت تر کردن کار کاربران خدمات مخفی شبکه تور در دسترسی و جستجوی پسوند های مخفی .onion، آرون سوارتز Tor2web را طراحی کرد. این برنامه پراکسی می تواند دسترسی به این خدمات را از طریق مرورگر های معمولی نیز ممکن سازد. با استفاده از این برنامه، لینک های وب عمیق به صورت رشته های تصادفی از حروف با پسوند .onion ظاهر می شوند.